Teorie informace: Porovnání verzí

Značka: editace z Vizuálního editoru |

|||

| (Není zobrazeno 6 mezilehlých verzí od stejného uživatele.) | |||

| Řádek 1: | Řádek 1: | ||

| − | Tato teorie byla definovaná C. E. Shannonem jako "snížení neurčitosti systému" a matematicky vyjádřená jako logaritmus pravděpodobnosti nějakého jevu (přenosu zprávy) při rovnoměrném rozložení hustoty pravděpodobnosti. Pro pravděpodobnost 1/2 při dvojkovém logaritmu dostaneme jednotku zvanou bit. Bit je pouze míra informace, jako je metr nebo coul mírou vzdálenosti. | + | Tato teorie byla definovaná C. E. [[Claude Shannon |Shannonem]] jako "snížení neurčitosti systému" a matematicky vyjádřená jako logaritmus pravděpodobnosti nějakého jevu (přenosu zprávy) při rovnoměrném rozložení hustoty pravděpodobnosti. Pro pravděpodobnost 1/2 při dvojkovém logaritmu dostaneme jednotku zvanou [[Bit – jednotky informace|bit]]. Bit je pouze míra informace, jako je metr nebo coul mírou vzdálenosti. |

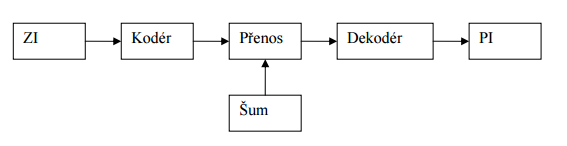

== Základní schéma == | == Základní schéma == | ||

| + | [[Soubor:Teorie.png]] | ||

* ZI: zdroj informace – člověk, stroj nebo příroda | * ZI: zdroj informace – člověk, stroj nebo příroda | ||

* Kodér: informace je zakódována (= zpráva) | * Kodér: informace je zakódována (= zpráva) | ||

| Řádek 17: | Řádek 18: | ||

* Délka slova = počet znaků ve slově | * Délka slova = počet znaků ve slově | ||

| − | Kódování je převedení informace do zadaného kódu, případně převedení informace z jednoho kódu do druhého kódu. Při binárním kódování abeceda obsahuje pouze dva znaky 0 a 1 tj. A = {0,1}. Kód je zadán, pokud je zadána množina kódových slov, tj. podmnožina množiny všech možných slov. Obvykle je množina kódových slov zadána nějakou soustavou podmínek. V blokovém kódu je zpráva je rozdělena do částí (bloku) o stejné délce, každý blok je zakódován samostatně a zakódované bloky jsou spojeny do zakódované zprávy. | + | [[Kódování]] je převedení informace do zadaného kódu, případně převedení informace z jednoho kódu do druhého kódu. Při binárním kódování abeceda obsahuje pouze dva znaky 0 a 1 tj. A = {0,1}. Kód je zadán, pokud je zadána množina kódových slov, tj. podmnožina množiny všech možných slov. Obvykle je množina kódových slov zadána nějakou soustavou podmínek. V blokovém kódu je zpráva je rozdělena do částí (bloku) o stejné délce, každý blok je zakódován samostatně a zakódované bloky jsou spojeny do zakódované zprávy. |

=== Množství informace === | === Množství informace === | ||

| − | 1 bit = jednotka informace = množství informace obsažené v binárním slově o délce jedna | + | 1 [[Bit – jednotky informace|bit]] = jednotka informace = množství informace obsažené v binárním slově o délce jedna |

| + | |||

| + | [[Soubor:SchemaCS.png]] | ||

== Základní pojmy == | == Základní pojmy == | ||

| Řádek 31: | Řádek 34: | ||

== Informace == | == Informace == | ||

| − | Pojem informace patří k nejobecnějším kategoriím současné vědy i filozofie, řadí se mezi takové pojmy jako hmota, vědomí, myšlení, poznání, pohyb, čas. Pojem informace představuje sdělovaná fakta, poznatek, údaj, zpráva. To, co neustále vzniká mezi člověkem a světem, formuje ho (in formare = utvářet). I o sobě podává každý předmět. Buď se odplaví, nebo se uloží do poznatkového fondu (informace => poznatky). Jedná se o obsah toho, co se vymění s vnějším světem, jemuž se přizpůsobujeme a na nějž působíme. Může být fyzikální, biologické, sociální (konvenční, masová, odborná), strojové | + | Pojem [[informace]] patří k nejobecnějším kategoriím současné vědy i filozofie, řadí se mezi takové pojmy jako hmota, vědomí, myšlení, poznání, pohyb, čas. Pojem informace představuje sdělovaná fakta, poznatek, údaj, zpráva. To, co neustále vzniká mezi člověkem a světem, formuje ho (in formare = utvářet). I o sobě podává každý předmět. Buď se odplaví, nebo se uloží do poznatkového fondu (informace => poznatky). Jedná se o obsah toho, co se vymění s vnějším světem, jemuž se přizpůsobujeme a na nějž působíme. Může být fyzikální, biologické, sociální (konvenční, masová, odborná), strojové |

| + | |||

| + | == Odkazy == | ||

| + | |||

| + | === Použitá literatura === | ||

| + | # Claude E. Shannon, Warren Weaver. The Mathematical Theory of Communication. Univ of Illinois Press, 1949. ISBN 0-252-72548-4 | ||

| + | # CEJPEK, Jiří. Informace, komunikace a myšlení. Praha: Karolinum, 1998. 179 s. ISBN 80-7184-767-4. | ||

| + | |||

| + | === Související články === | ||

| + | * [[Claude Shannon]] | ||

| + | * [[Bit – jednotky informace|Bit]] | ||

| + | * [[Kódování]] | ||

| + | * [[Informace]] | ||

| + | |||

| + | === Klíčová slova === | ||

| + | teorie informace, Claude Shannon, bit, kódování, informace | ||

| − | + | [[Kategorie:Informační studia a knihovnictví]] | |

| − | + | [[Kategorie: Teoretické a obecné aspekty knihovnictví a informací]] | |

| + | [[Kategorie: Státnicové otázky UISK]] | ||

| + | [[Kategorie:Články k ověření učitelem Souček M]] | ||

Aktuální verze z 8. 6. 2018, 11:01

Tato teorie byla definovaná C. E. Shannonem jako "snížení neurčitosti systému" a matematicky vyjádřená jako logaritmus pravděpodobnosti nějakého jevu (přenosu zprávy) při rovnoměrném rozložení hustoty pravděpodobnosti. Pro pravděpodobnost 1/2 při dvojkovém logaritmu dostaneme jednotku zvanou bit. Bit je pouze míra informace, jako je metr nebo coul mírou vzdálenosti.

Obsah

Základní schéma

- ZI: zdroj informace – člověk, stroj nebo příroda

- Kodér: informace je zakódována (= zpráva)

- Přenos: zakódovaná zpráva je poškozena šumem

- Dekodér: odkódováné zprávy (převedené do řeči, písma apod.)

- PI: příjemce informace

Zde je vidět, že informace není to, co máme v hlavě, ale to, co dokážeme sdělit někomu jinému. Přitom je jasné, že neexistuje způsob, kdy dekódovaná informace je úplně shodná s původní informací – sémantický obsah přenesený k příjemci není úplně shodný se sémantickým obsahem na straně zdroje informace.

Odtud je jasné, že pojem informace má mnoho rovin a že je těžké definovat pojem informace v plném rozsahu. Zároveň je jasné, že základním prvkem zpracování informace (tak aby vůbec mohla být přenesena od původce k příjemci) je kódování, tj. převedení informace do nějakého řetězce znaků (znaky mohou být např. také fonémy). Uvedeny jsou základní principy kódování.

Kódování

- Abeceda je (konečná) množina znaků používaných v daném kódu.

- Slovo = konečná posloupnost znaků z dané abecedy

- Délka slova = počet znaků ve slově

Kódování je převedení informace do zadaného kódu, případně převedení informace z jednoho kódu do druhého kódu. Při binárním kódování abeceda obsahuje pouze dva znaky 0 a 1 tj. A = {0,1}. Kód je zadán, pokud je zadána množina kódových slov, tj. podmnožina množiny všech možných slov. Obvykle je množina kódových slov zadána nějakou soustavou podmínek. V blokovém kódu je zpráva je rozdělena do částí (bloku) o stejné délce, každý blok je zakódován samostatně a zakódované bloky jsou spojeny do zakódované zprávy.

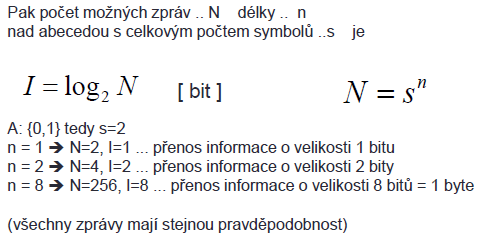

Množství informace

1 bit = jednotka informace = množství informace obsažené v binárním slově o délce jedna

Základní pojmy

- Zpráva - jakákoliv posloupnost rozlišitelných znaků

- Symboly - rozlišitelné prvky ve zprávě (grafické znázornění … znaky)

- Abeceda - množina všech symbolů

- Signál - materiální nositel zprávy

- Kódování - transformace zprávy vyjádřené pomocí 1 abecedy na zprávu vyjádřenou pomocí 2. abecedy

- Informace - vztah mezi symboly zprávy a okolním světem

Informace

Pojem informace patří k nejobecnějším kategoriím současné vědy i filozofie, řadí se mezi takové pojmy jako hmota, vědomí, myšlení, poznání, pohyb, čas. Pojem informace představuje sdělovaná fakta, poznatek, údaj, zpráva. To, co neustále vzniká mezi člověkem a světem, formuje ho (in formare = utvářet). I o sobě podává každý předmět. Buď se odplaví, nebo se uloží do poznatkového fondu (informace => poznatky). Jedná se o obsah toho, co se vymění s vnějším světem, jemuž se přizpůsobujeme a na nějž působíme. Může být fyzikální, biologické, sociální (konvenční, masová, odborná), strojové

Odkazy

Použitá literatura

- Claude E. Shannon, Warren Weaver. The Mathematical Theory of Communication. Univ of Illinois Press, 1949. ISBN 0-252-72548-4

- CEJPEK, Jiří. Informace, komunikace a myšlení. Praha: Karolinum, 1998. 179 s. ISBN 80-7184-767-4.

Související články

Klíčová slova

teorie informace, Claude Shannon, bit, kódování, informace