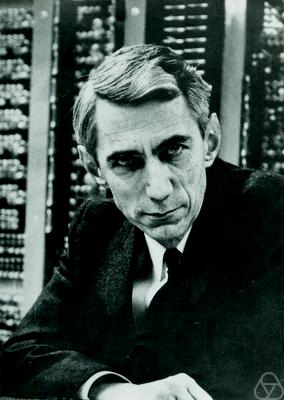

Claude Shannon

Claude Elwood Shannon (30. dubna 1916 - 24. února 2001) byl americký matematik, kybernetik, elektroinženýr, "otec teorie informace" a zakladatel informatiky a digitální komunikace, známý především díky svému matematickému modelu komunikace, tzv. Shannon a weaver model. Byl také zakladatelem teorie návrhu digitálních elektrických obvodů. Poprvé použil pro informaci jednotku – bit (jako zkratku slov - binary diary – dvojková číslice). Ta je vyjádřena jako množství informace obsažené v jednom binárním slově. Jako první definoval entropii termodynamiky jako míru nejistoty na rozdělení pravděpodobnosti.

Obsah

Život

C. E. Shannon se narodil v Petoskey v Michiganu. Otec Claude Elwood Shannon pracoval jako soudce v Gaylordu, kde celá rodina žila, a matka Mabel Wolf Shannon byla ředitelka střední školy tamtéž.[1] V Gaylordu vystudoval Shannon střední školu a již v této době se zajímal o radioamatérismus a dálkově řízené modely - jeho vzorem byl Thomas Alva Edison.[2] Během střední školy pracoval jako doručovatel společnosti Western Union.[3]

Studium

Po střední škole v roce 1932 nastoupil na University of Michigan. Začal studovat elektroinženýrství, ke kterému si nakonec přidal matematiku, a roku 1936 získal v obou oborech B.S. degree[1] - ekvivalent českého Bc. Poté nastoupil na Massachusetts Institute of Technology (MIT), kde začal pracovat jako asistent týmu konstruktérů diferenciálniho analyzátoru pod vedením Vannevara Bushe[4], a v roce 1937 napsal diplomovou práci A Symbolic Analysis of Relay and Switching Circuits, která používá Booleovu algebru pro návrh reléových sítí. [5] Podle harvardského profesora Howarda Gardnera to byla pravděpodobně nejdůležitější a nejslavnější diplomová práce století. Na MIT získal magisterský titul v elektroinženýrství a PhD v matematice v roce 1940 za disertační práci An Algebra for Theoretical Genetics.[3]

Dílo a práce

C. E. Shannon se ve svém výzkumu pohyboval ve střetu více oborů a i díky tomu začal koncem studia pokládat první teze, na kterých dnes stojí informační věda. Po roce 1942 odešel do matematického oddělení Bellových laboratoří, zde také uvedl teorii spínacích obvodů, která vzbudila ve vědeckém světě velký ohlas. Když podle ní vědci z Bellových laboratoří poprvé vytvořili návrhy telefonních ústředen, přesvědčili se o tom, jaký mocný nástroj v této teorii získali.[6]

Základní princip digitálního počítače

Shannon vypracoval diplomovou práci, která měla dalekosáhlé následky. Vytvořila základ, na němž stojí princip digitálního počítače. Nesnáze, které dělaly těžkou hlavu raným počítačovým průkopníkům od Babbage až po Mauchlyho, byly totiž způsobeny i lpěním na desítkové soustavě. Shannon přesvědčivě dokázal, že těmto problémům se lze vyhnout pomocí logiky založené na extrémně malé množině, obsahující jen dva prvky: jedničku a nulu (resp. zapnuto a vypnuto).[7]

Teorie informace

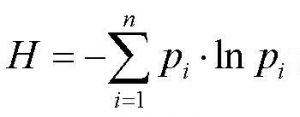

Informace je zpráva, která snižuje neznalost (neurčitost) o stavu systému. Systém má n možných stavů, pravděpodobnosti jejich výskytu, přičemž musí platit: pak množství informace nutné k odstranění neurčitosti o stavu systému (tzv. Shannonova entropie) je dáno následujícím vzorcem:[8]

Tato kvantitativní teorie informace vychází z předpokladu, že počet stavů systému je známý a konečný, že jsou navíc známy pravděpodobnosti výskytů stavů.

Vznik Teorie informace

Na počátku Teorie informace byly Shannonovy otázky, co je to vlastně informace? Jakým způsobem lze informaci měřit? Jak ji porovnávat v přenosu ve vysílaných a přijímaných zprávách?Tyto otázky souvisely jak s problematikou telekomunikací, tak i kryptografií, při níž vědci, aniž se nad tím většina z nich takto pozastavovala, luštili zašifrované skupiny písmen zdánlivě bez jakéhokoli smyslu. Jejich úkolem vlastně bylo velikost informace oddělit od obsahového kontextu, což nezřídka znamenalo rozložit zprávu na nejmenší části, tedy jednotlivé znaky, a pak zkoumat informaci nesenou jediným znakem. Shannon neučinil nic menšího, než že se pokusil tyto procesy spojené s rozpoznáním a přenosem informace na základě statistiky matematicky vyjádřit. Aby to bylo možné, musel nejprve identifikovat univerzální jednotku informace. Označil ji jako „binary digit“ neboli zkráceně „bit“, přičemž stanovil, že jeden bit reprezentuje informaci získanou odpovědí na jednu otázku typu ano/ne, u které je apriorní pravděpodobnost obou odpovědí stejná (odpověď pak lze vyjádřit jednou z dvojice číslic 0 či 1). Na základě tohoto určení kapacity sdělovacího kanálu (či média) rozvinul Shannon jak teorii přenosu dat (bez ohledu na jejich sémantiku), tak teorii datové komprese (související s kritériem věrnosti reprodukce zprávy). Obě tyto teorie pak vzájemně propojil a vyvážil ve větách o přenosech informací a oddělením zdrojů informace od sdělovacích kanálů, přičemž definoval pojem informační entropie, charakterizovaný jako neurčitost (popřípadě organizovanost) celého zdroje jakožto průměru z informací nesených jeho jednotlivými znaky.[9]

Matematická teorie komunikace

Shannon a weaver model Vydaná v roce 1948, pokusil se v ní vše matematicky popsat a zároveň určit základní jednotku informace. Označil ji jako „binary digit“ neboli zkráceně „bit“, přičemž stanovil, že jeden bit reprezentuje informaci získanou odpovědí na jednu otázku typu ano/ne, u které je apriorní pravděpodobnost obou odpovědí stejná (odpověď pak lze vyjádřit jednou z dvojice číslic 0 či 1). Na základě tohoto určení kapacity sdělovacího kanálu (či média) rozvinul Shannon jak teorii přenosu dat (bez ohledu na jejich sémantiku), tak teorii datové komprese (související s kritériem věrnosti reprodukce zprávy).[10]

Odkazy

Reference

- ↑ Skočit nahoru k: 1,0 1,1 Claude Shannon [online]. [cit. 2016-02-09]. Dostupné z: https://www.nyu.edu/pages/linguistics/courses/v610003/shan.html Chybná citace: Neplatná značka

<ref>; název „test“ použit vícekrát s různým obsahem - ↑ C. E. Shannon – průkopník informačního věku [online]. 2004(8) [cit. 2016-02-09]. Dostupné z: http://casopis.vesmir.cz/clanek/c-e-shannon-prukopnik-informacniho-veku

- ↑ Skočit nahoru k: 3,0 3,1 MIT Professor Claude Shannon dies; was founder of digital communications, MIT News. Chybná citace: Neplatná značka

<ref>; název „test5“ použit vícekrát s různým obsahem - ↑ [Průkopníci informačního věku (10.): Claude Shannon [online]. 2010 [cit. 2016-02-09]. Dostupné z: http://businessworld.cz/cio-bw-special/prukopnici-informacniho-veku-10-claude-shannon-6969], CIO Business World.cz.

- ↑ A Symbolic Analysis of Relay and Switching Circuits, 10. srpna 1937.

- ↑ Průkopníci informačního věku [online]. [cit. 2016-02-12].Dostupné z: http://businessworld.cz/cio-bw-special/prukopnici-informacniho-veku-10-claude-shannon-6969

- ↑ Průkopníci informačního věku (10.): Claude Shannon [online]. [cit. 2016-02-10]. Dostupné z: http://businessworld.cz/cio-bw-special/prukopnici-informacniho-veku-10-claude-shannon-6969

- ↑ Teorie informace [online]. [cit. 2016-02-09]. Dostupné z: http://www.tucekweb.info/Teo_inf/Teo_inf.html

- ↑ Průkopníci informačního věku (10.): Claude Shannon [online]. [cit. 2016-02-10]. Dostupné z: http://businessworld.cz/cio-bw-special/prukopnici-informacniho-veku-10-claude-shannon-6969

- ↑ Úsvit hackerů: závěr s Claudem Shannonem [online]. In: . [cit. 2016-02-09]. Dostupné z: http://www.root.cz/clanky/usvit-hackeru-zaver-s-claudem-shannonem/

Použitá literatura

SLUKOVÁ, Petra. Informace a komunikace [online]. [cit. 2016-02-12]. Dostupné z: http://www.informacniveda.cz/article.do?articleId=1132

Externí odkazy

- http://www.root.cz/clanky/usvit-hackeru-zaver-s-claudem-shannonem

- http://www.tucekweb.info/Teo_inf/Teo_inf.html

- http://businessworld.cz/cio-bw-special/prukopnici-informacniho-veku-10-claude-shannon-6969

Související články

Klíčová slova

Teorie informace, Claude Shannon, Komunikace, jednotka informace